近日,IEEE Transactions on Neural Networks and Learning Systems在线发表了江南大学未来食品科学中心崔晓晖教授课题组的研究成果“IFL-GAN: Improved Federated Learning Generative Adversarial Network With Maximum Mean Discrepancy Model Aggregation”(Li et al., IEEE Transactions on Neural Networks and Learning Systems, 2022)。 江南大学李伟副教授为论文第一作者。

研究正文:生成对抗网络通常由集中的、独立同分布的训练数据构建,以生成类似真实的实例。然而,在现实世界的应用程序中,数据可能分布在多个客户端上,并且由于带宽、部门协调或存储问题而难以收集。为此,联邦学习 GAN (FL-GAN)采用不同的分布式策略来训练 GAN 模型,但当数据以非独立同分布的方式分布时仍然存在局限性。我们发现使用联邦平均策略聚合更新局部GAN模型通常导致收敛困难,生成的数据质量低等问题。在本文中,我们提出了改进的 FL-GAN(IFL-GAN)作为一种解决此问题的替代方法,该方法通过聚合具有最大均值差异 (MMD) 的本地训练生成器的更新来学习全局共享的 GAN 模型。MMD 分数帮助每个局部 GAN 保持不同的权重,使得 IFL-GAN 中的全局 GAN 比联邦平均更快地收敛。在 MNIST、CIFAR10 和 SVHN 数据集上进行的大量实验证明了我们的 IFL-GAN 在实现最高初始分数和生成高质量实例方面的显着改进。

上述研究工作得到了中央高校基本科研业务费专项资金(JUSRP121073、JUSRP521004)、2021年江苏省双创人才计划(JSSCBS20210827)、网络空间工程研究中心开放基金(KJAQ202112014)项目的支持。

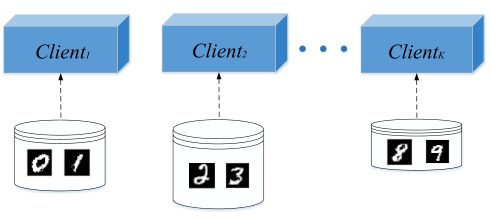

图1 非独立同分布数据分布于不同的客户端

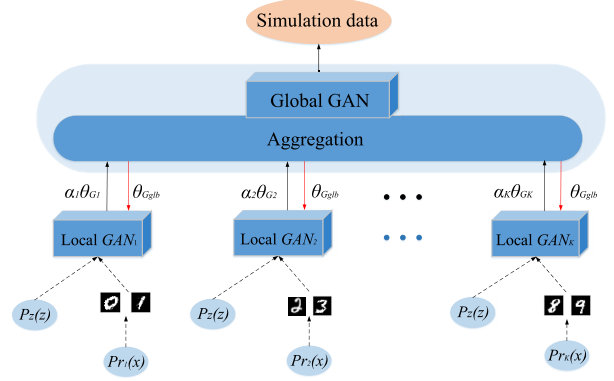

图2 IFL-GAN结构

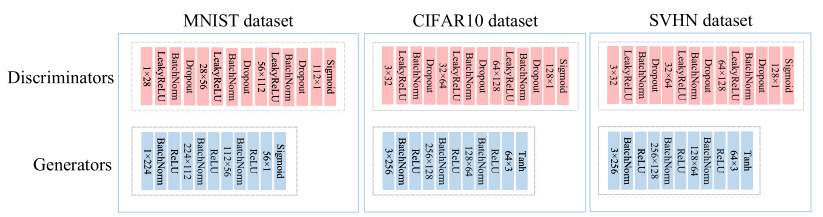

图3 MNIST、CIFAR10 和 SVHN 数据集的IFL-GAN架构细节

(编辑:潘梦妍)